-

[AWS] Spark 설치AWS 2021. 11. 22. 17:59

이번에는 스파크를 설치를 할텐데 그전에 java와 scala를 설치를 해야한다.

1. java 설치 및 환경 변수

1-1 java 설치

아래 코드로 설치를 진행했다.

scala와 잘 연동된다 하여 버전 8을 설치했다.

$ sudo apt install openjdk-8-jdk1-2 설치 확인

$ java -version

1-3 환경 변수 설정

다음 코드로 porfile 열어주자.

$ sudo nano /etc/profile자 그럼 열게되면 밑으로 쭉내려서 아래코드 입력을 해주면 된다.

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64 export PATH=$JAVA_HOME/bin:$PATH export CLASS_PATH=$JAVA_HOME/lib:$CLASS_PATH

여기서 저장하고 나가는 방법은 CTRL + X -> Y -> Enter 순으로 눌러 나가면 된다. 변수 설정 후 ubuntu를 종료후 다시 시작 해주면 환경 변수 설정이 적용 된다.

1-4 환경변수 설정 확인

아래 코드 입력 이코드는 java R 인식하기 위한 코드라 생각하자.

$ sudo R CMD javareconf아래 코드로 황경 변수 확인.

$ echo $JAVA_HOME

1-5 Rstudio-server 환경변수 지정 및 rJava 패키지 설치

아래 코드로 설정 및 설치를 해주면 끝!!!!

Sys.setenv(JAVA_HOME="/usr/lib/jvm/java-8-openjdk-amd64") install.packages('rJava')

2. Scala 설치 및 환경 변수 설정

- 2-1 Scala 설치

아래 코드로 설치 진행 해주자.

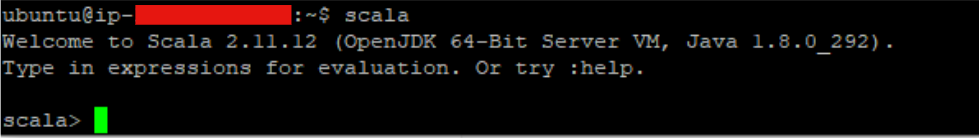

$ sudo apt-get install scala2-2 Scala 실행

$ scala

잘 실행 되는것을 확인했으니 :q 로 꺼주도록 하자.

2-3 환경 변수 설정

Java 설정과 동일하게 profile을 열어주도록 하자.

$ sudo nano /etc/profile동일하게 열렸으면 아래로 쭉~~ 내려가서 아래 코드 입력!!

export SCALA_HOME=/usr/bin/scala export PATH=$SCALA_HOME/bin:$PATH

위와 동일하게 저장하고 나가기는 CTRL + X -> Y -> Enter 순으로 나가면 된다.

3. Spark 설치 및 환경 변수

3-1 Spark 설치

- [Spark 홈페이지]에 들어가 버전을 선택하고 설치하자.

버전 선택후 아래 링크를 통해 들어가면 아래와 같이 나온다. 그러면 주소를 복사해주자.

자 그럼 준비는 끝낫다. 복사한 주소로 설치를 해주자.

버전이 수시로 바뀌니 홈페이지에 꼭 들어가 버전확인후 설치 진행해야 한다.

$ wget https://dlcdn.apache.org/spark/spark-3.2.0/spark-3.2.0-bin-hadoop2.7.tgz파일을 받았으니 압축을 풀어 주도록 하자.

$ tar xvf spark-3.2.0-bin-hadoop2.7.tgz3-2 환경 변수 설정

spark-3.2.0-bin-hadoop2.7 폴더가 생성 되었을 것이다. 이름도 길고 환경 변수 설정을 위해 변경해주도록 하자.

$ sudo mv spark-3.2.0-bin-hadoop2.7/ /usr/spark환경 변수설정을 위해 profiled 열어주도록 하자.

$ sudo nano /etc/profile또 동일하게 아래로 쭉 내려서 아래 코드 입력!

export SPARK_HOME=/usr/spark export PATH=$SPARK_HOME/bin:$PATH

위와 동일하게 저장하고 나가기는 CTRL + X -> Y -> Enter 순으로 나가면 된다.

다음 spark 실행을 해볼 것인데 ubuntu 종료 후 적용시키는 것보다 컴퓨터를 껏다 켜서 적용시켜보자. 무슨 이유인지 모르겠지만 나는 컴퓨터를 껏다 켜야 적용 되어서 시간을 낭비했다. 한텀 쉰다 생각하고 컴퓨터 재부팅을 해주자.!

3-3 Spark 실행 확인

아래 코드로 실행 및 확인

$ /usr/spark/bin/spark-shell println("spark is running")

실행도 잘되고 명령어도 잘 되는 것까지 확인하면 끝!!!!! 여기까지 잘 했다. 이제 다음 블로그에 jypyter notebook에서 pyspark를 연동하는것을 블로그에 올릴것이다. 여기까지 jypyter notebook에서 spark를 사용하기 위해 준비 작업이었다.

다음 블로그에서 연동까지 마무리 하도록 하자.

'AWS' 카테고리의 다른 글

[AWS]Rstudio-server 설치 (0) 2021.11.22 AWS 환경에서 Jupyter notebook 설치 및 실행 (0) 2021.10.07 [AWS] EC2 메모리 설정 (0) 2021.10.07 [AWS] EC2 구축 하기 (0) 2021.10.06