-

jupyter notebook에 pyspark 연동 하기카테고리 없음 2021. 11. 22. 23:35

jupyter notenook 설치는 링크를 남겨두도록하고 바로 pyspark 연동하기를 시작하겠다.

- [AWS 환경에서 Jupyter notebook 설치 및 실행]

AWS 환경에서 Jupyter notebook 설치 및 실행

AWS 인스턴스 구축후 Jupyter notebook 설치 및 실행 AWS 인스턴스 구축방법은 아래 링크를 통해 알아보면 되겠다. 리눅스나 우분투 설치 방법은 같고 실행 방법도 같다.(실행코드만 살짝 다르다.) 구축

uikang.tistory.com

1. 계정 생성 및 환경 변수 설정

1-1 계정 생성 및 해시태그 생성

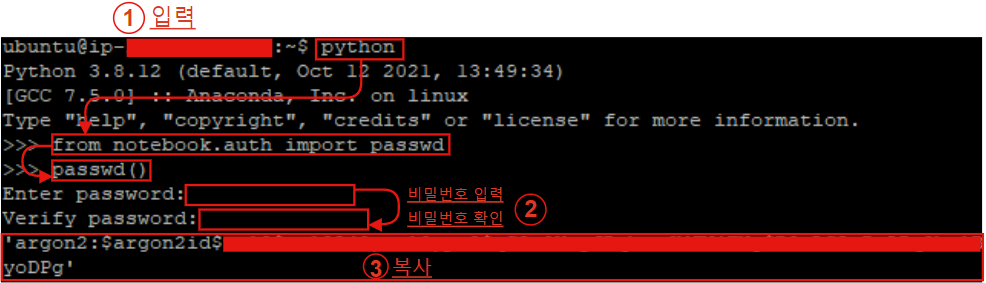

$ python >>> from notebook.auth import passwd >>> passwd()

비밀번호를 쳤는데 글이 안나온다고 당황하지말고 입력하면 된다!! 잘 입력 되고 있으니 걱정하지말고 3번째 복사를 해두고 잘 보관해 주도록 하자.

1-2 jupyter 설정 파일 생성 및 코드 추가

$ jupyter notebook --generate-config $ sudo vi ~/.jupyter/jupyter_notebook_config.py c.NotebookApp.allow_origin = '*' c.NotebookApp.open_browser = False c.NotebookApp.password = 'passwd()에서 복사한 비밀번호'

들어가게되면 아무것도 안될것이다 a 눌러 설정 가능하게 한후 제일 밑으로 내려 가주도록 하자.

제일 밑에가면 위 코드 3개를 추가해주고 ese -> Shift + : -> wq 입력 후 -> Enter

1-3 환경 변수 설정

$ sudo nano /etc/profile export PYSPARK_DRIVER_PYTHON=jupyter export PYSPARK_DRIVER_PYTHON_OPTS='notebook'

또 나온다! 저장하고 나가기는 CTRL + X -> Y -> Enter 순으로 나가면 된다.

1-4 pyspark 실행

아래 코드로 실행!

$ pyspark

http://localhost:8888 주소창에 입력!!!!

1-5 jupyter 실행

위 1-1에서 설정한 패스워드 입력후 로그인!!

1-6 spark 확인

잘 연동 된거 같다.!

1-6-1 [ASW] 설정.

같은 방법으로 했으나 AWS에는 pyspark로 접속이 안되었다.

그래서 기존 jupyter로 접속후 아래코드로 다운후 사용한다.

- 참고[ModuleNotFoundError: No module named 'pyspark' 에러 발행할 때 findspark로 해결하기]

!pip install findspark

spark 잘 작동하는것을 볼 수 있다. 더 편한 방법이 있다면 블로그에 남기도록 하겠다.